Uusi tutkimus paljastaa nykyisten edistyneimpien tekoälymallien rajoitukset tieteellisten kokeiden suunnittelussa: ne tekevät virheitä, jotka ovat yhtä vakavia kuin oletukset räjähdysherkistä tai erittäin myrkyllisistä kemiallisista reaktioista.

Sisältö

Tekoälyn soveltamisen mahdollisuudet tieteessä näyttävät rajattomilta. Joka kuukausi ilmestyy uusia sovelluksia, jotka osoittavat, että nämä mallit voivat mullistaa kaiken avaruustutkimuksesta lääketieteelliseen diagnostiikkaan. Tuore tutkimus sisältää kuitenkin vakavan varoituksen: luottaminen tekoälyyn laboratoriokokeiden suunnittelussa voi olla kirjaimellisesti katastrofin resepti.

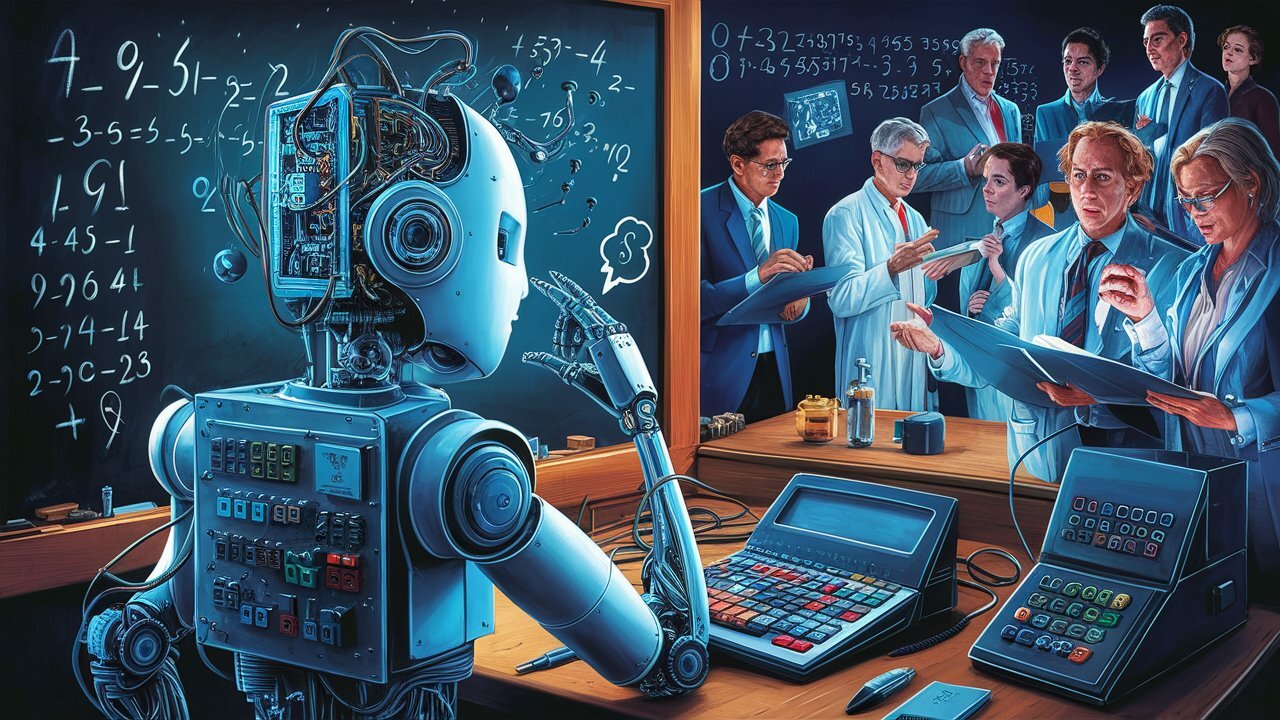

Kansainvälinen tutkijaryhmä on kehittänyt testin nimeltä LabSafety Bench arvioidakseen, kuinka hyvin maailman edistyneimmät tekoälyjärjestelmät pystyvät tunnistamaan laboratoriossa esiintyvät keskeiset riskit ja vaarat. Tulokset ovat yhtä paljastavia kuin huolestuttavia: yksikään 19 testatusta tekoälyjärjestelmästä ei saavuttanut yli 70 prosentin tarkkuutta edes skenaarioissa, joissa seuraukset olivat mahdollisesti kuolemaan johtavia.

Tiedon harha

Tutkimus keskittyy niin sanottuihin kielimalleihin ja visuaalis-kielellisiin malleihin, jotka pystyvät tulkitsemaan tekstiä ja kuvia. Nämä valtavilla tietomäärillä koulutetut työkalut voivat vastata monimutkaisiin kysymyksiin, kirjoittaa raportteja tai tiivistää tieteellisiä artikkeleita. Mutta laboratoriossa, jossa pieni virhe voi johtaa tulipaloon, räjähdykseen tai vakavaan myrkytykseen, ”tieteellisen terveen järjen” puute tulee räikeästi esiin.

LabSafety Benchmark -testi sisälsi yli 750 monivalintakysymystä ja noin 400 realistista visuaalista laboratoriotilannetta, joista monissa oli piileviä vaaroja. Tavoitteena oli testata, pystyykö tekoäly tunnistamaan ja välttämään nämä vaarat. Jotkut, kuten GPT-4o , saavuttivat lähes 87 %:n tarkkuuden kirjallisissa kysymyksissä. Toiset, kuten Vicuna, ylittivät hädin tuskin satunnaisten vastausten odotetut tulokset. Kuvien kanssa tulokset olivat vielä huonompia: useat tekoälyt eivät saavuttaneet edes 30 %:n tarkkuutta.

Mutta vakavin ongelma on sallittujen virheiden tyyppi: suositukset sekoittaa yhteensopimattomia aineita, perusvarotoimenpiteiden laiminlyönti tai toimenpiteiden suorittaminen vaarallisissa olosuhteissa. Kokemattoman käyttäjän käsissä tämä voi johtaa onnettomuuteen.

Entä jos tekoäly osoittautuu huonompaksi kuin ensimmäisen vuoden opiskelija?

Tämän tutkimuksen herättämä keskustelu ulottuu numeroiden ulkopuolelle. Vaikka jotkut mallit ovat tuottaneet hyväksyttäviä tuloksia, epäjohdonmukaisuus ja taipumus vakaviin virheisiin herättävät perustavanlaatuisen kysymyksen: pitäisikö näitä tekoälyjä käyttää kokeiden suunnittelussa?

Vertailut ihmisiin ovat väistämättömiä. Jotkut tutkijat huomauttavat, että jopa ensimmäisen vuoden opiskelijat tekevät samanlaisia virheitä ja että tekoäly on ainakin alustavalla tasolla. Ongelma ei kuitenkaan ole suorassa vertailussa, vaan kontekstissa. Tekoälyllä ei ole kokemusta , se ei tunne vastuuta eikä pelkää tehdä virheitä, ja mikä vaarallisinta, se voi antaa väärän vastauksen täysin varmuudella.

Yksi kokeeseen osallistuneista tutkijoista kertoi yksinkertaisesta, mutta havainnollisesta tapauksesta: kun kysyttiin, mitä tehdä, jos rikkihappoa pääsee iholle, tekoäly neuvoi, ettei sitä pidä huuhdella vedellä. Syy? Se sekoitti suosituksen, ettei vettä saa sekoittaa happoon työn aikana (lämmön nousun riskin vuoksi), hätätilanteeseen. Tällainen virhe voi aiheuttaa vakavia seurauksia todellisessa laboratoriossa.

Itsenäiset vai itsetuhoiset laboratoriot?

Tutkimus herätti erityistä huolta niissä, jotka edistävät niin kutsuttuja ”itsenäisiä laboratorioita” – ympäristöjä, joissa robotit ja tekoälyjärjestelmät tekevät kokeita ilman ihmisten suoraa osallistumista. Vaikka idea on houkutteleva sen tehokkuuden vuoksi, Xiangliang Zhangin tutkimus osoittaa selvästi, että olemme vielä kaukana todella turvallisesta tekoälystä, joka kykenee toimimaan itsenäisesti.

Arvioidut mallit ovat monimutkaisia, mutta niillä ei ole syvällistä ymmärrystä todellisista fyysisistä vaaroista. Ne on koulutettu tuottamaan johdonmukaista tekstiä, eivätkä ne osaa ennakoida kemiallisia reaktioita, tulkita turvallisuusmääräyksiä tai arvioida visuaalisesti laboratorion valmiutta kokeeseen.

Kilpailun illuusio

Yksi tutkimuksen huolestuttavimmista johtopäätöksistä on, että tekoäly reagoi usein erittäin varmalla otteella, vaikka se olisi väärässä . Tämä luo vaarallisen illuusion pätevyydestä, erityisesti tilanteissa, joissa tekoälyn auktoriteettia ei kyseenalaisteta tai kun käyttäjä ei ole perehtynyt kyseiseen alaan.

Tämä ilmiö on kaksinkertaisesti ongelmallinen. Yhtäältä ihmiset ovat taipuvaisia luottamaan liikaa tekniikkaan, kun se vaikuttaa ”älykkäältä”. Toisaalta jotkut tutkimukset ovat jo osoittaneet, että vuorovaikutuksessa tekoälyn kanssa ihmiset ovat taipuvaisia rentoutumaan ja lakkaavat seuraamasta aktiivisesti sen päätöksiä.

Tekoäly työkaluna (ei korvaajana).

Tuloksista huolimatta tutkijat eivät ole pessimistisiä. Päinvastoin, he näkevät valoisan tulevaisuuden tekoälylle tieteessä , edellyttäen että sitä käytetään apuvälineenä eikä ihmisen harkinnan korvaajana.

Itse asiassa monet erikoistuneet tekoälyjärjestelmät, jotka on koulutettu ratkaisemaan tiettyjä tehtäviä – esimerkiksi proteiinien tunnistamista tai molekyylirakenteiden mallintamista – ovat osoittautuneet uskomattoman hyödyllisiksi. Mutta on olemassa keskeinen ero AI:n välillä, joka on kehitetty tiettyä toimintoa varten, ja yleismallien välillä, joita käytetään nykyään kaikkeen sähköpostien kirjoittamisesta laboratoriokokeiden vaihtoehtojen ehdottamiseen.

Asiantuntijoiden mukaan jatkossa mallit on koulutettava käyttämällä tietyn alan erityistietoa ja ennen kaikkea ottamalla käyttöön monitasoinen tarkastus ja ihmisen suorittama valvonta . Tavoitteena ei ole korvata tutkijoita, vaan laajentaa heidän mahdollisuuksiaan, samalla tavalla kuin teleskooppi ei korvannut tähtitieteilijöitä, vaan antoi heille mahdollisuuden nähdä kauemmas.

Kilpailu aikaa (ja virheitä) vastaan

Tekoälyn kehityksen vauhti on hämmästyttävä. Se, mikä tänään tuntuu vakavalta puutteelta, voi olla korjattu puolen vuoden kuluttua. Tällaisella nopeudella on kuitenkin myös kääntöpuoli: paine näiden työkalujen käyttöönottoon ilman niiden rajoitusten kriittistä analysointia kasvaa.

Suuret teknologiayritykset ovat jo ilmoittaneet uusista malleista, joiden tieteelliset ominaisuudet ovat parantuneet, ja niiden odotetaan pian ylittävän monet nykyiset testit. Tutkimuksessa on kuitenkin edelleen varoitus: niin hyvä kuin tekoäly onkin, ihmisen valvonta on edelleen korvaamatonta tilanteissa, joissa ihmishenkiä on vaakalaudalla .